探索Spark需求的关键因素及应用(从性能到应用场景,解密Spark需求的核心要素)

在大数据时代,Spark作为一种快速而强大的分布式计算框架,被广泛应用于各行各业。了解并满足Spark的需求是提高数据处理效率和质量的关键。本文将探讨Spark需求的主要影响因素以及其在不同场景下的应用。

Spark版本对需求的影响

随着Spark的不断发展,不同版本之间的需求也有所差异。从Spark1.x到2.x再到3.x,每个版本都带来了新功能和性能优化。了解不同版本的需求是确保系统兼容性和性能提升的关键。

硬件配置与Spark需求的匹配

Spark对硬件配置有一定的要求,包括CPU核心数、内存容量、磁盘空间等。不同规模的数据处理任务对硬件配置的需求也有所不同。合理配置硬件资源能够最大化地满足Spark的需求。

数据量和数据类型对需求的影响

大数据处理是Spark的强项,因此数据量是影响需求的重要因素。大规模数据处理需要更高的计算能力和存储资源。此外,不同数据类型也对Spark的需求有所影响,如处理结构化数据和处理图数据的需求差异明显。

任务调度与并行度需求

Spark的任务调度和并行度对系统性能和资源利用率有着重要影响。合理的任务调度策略和适当的并行度设置能够最大化地发挥Spark的计算能力。

数据输入输出与Spark需求

数据输入输出是Spark的重要组成部分,影响着系统的整体性能。不同的数据源和数据格式对Spark的需求有所差异,如读取大文件和读取分布式存储系统的需求差异较大。

网络通信与Spark需求

分布式计算离不开高效的网络通信,而网络通信的性能也会直接影响Spark的需求。合理配置网络环境、优化网络传输速度和减少网络延迟是提高Spark性能的关键。

缓存机制与Spark需求

Spark的缓存机制对于重复计算和数据复用起着重要作用。了解如何合理使用Spark的缓存机制,可以减少不必要的计算开销,提高系统性能。

并行算法与Spark需求

Spark支持丰富的并行算法,不同算法对系统资源的需求也有所不同。了解并选择合适的并行算法能够更好地满足Spark的需求,并提高计算效率。

任务调优与Spark需求

对于复杂的数据处理任务,合理调优是保证系统性能的关键。了解Spark的任务调优技巧,包括优化代码、调整资源分配等,能够最大化地满足系统需求。

实时计算场景下的Spark需求

实时计算对Spark的需求有着特殊要求,包括低延迟、高吞吐量等。了解实时计算场景下Spark的需求,并根据需求进行系统配置和优化,能够更好地满足业务需求。

机器学习与Spark需求

机器学习是大数据处理中的热点领域,Spark作为机器学习框架也有自己的需求。了解机器学习算法对Spark的需求,选择合适的算法和模型训练策略,能够更好地满足机器学习任务的要求。

图计算与Spark需求

图计算是另一个重要应用场景,对Spark的需求也有所不同。了解图计算任务的特点,选择合适的图计算算法和调优策略,可以更好地满足图计算需求。

容错性与Spark需求

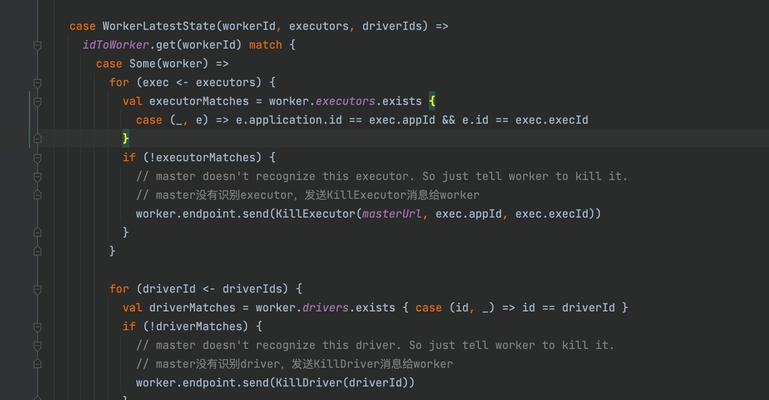

Spark作为分布式计算框架,对容错性有着较高的要求。了解如何处理节点故障、数据丢失等异常情况,能够保证系统的稳定性和可靠性。

安全性与Spark需求

随着数据泄露和隐私泄露的风险增加,数据安全成为各行业的重要关注点。了解Spark的安全特性和需求,配置合适的安全机制和权限管理,能够保护数据的安全和隐私。

本文从不同角度探讨了Spark需求的关键因素及其在不同应用场景下的应用。了解并满足Spark的需求是提高数据处理效率和质量的关键,同时也是实现大数据应用的基础。通过合理配置硬件资源、优化任务调度和并行度、选择合适的算法和模型训练策略等手段,可以最大程度地满足Spark的需求。